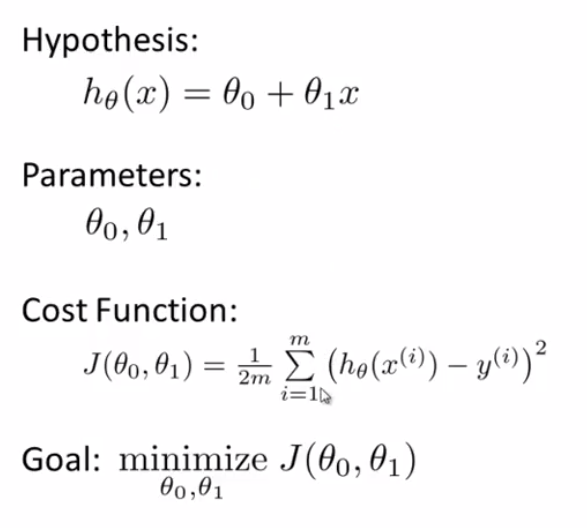

深度學習需要解決一個高維且非凸優化之問題,解決這些問題的難點在於,他可能具有多個好的解(local minimum),導致學習演算法(神經網路/loss)難以收斂到一個全域最佳值(global minimum)

這種問題在隨機優化領域(stochastic optimization)中,被稱為優化演算法的收斂問題(problems with the convergence of the optimization algorithm on a solution),而需要被收斂的解,在演算法中為一組權重(weight values),深度學習也屬於隨機優化領域,因此也面臨此問題,其權重通常以.h5檔案格式儲存

觀察神經網路訓練時每一個 epoch 的 loss,若不斷震盪,且平均來說不下降,則表示無法收斂